LoRA: Revolucija u Fine-Tuningu Modela sa Manje Resursa i Parametara

Share

Table of Contents

- Ključne Tačke

- Uvod

- Dilema Fine-Tuninga: Zašto je Veličina Bitna?

- Novi Pristup: LoRA kao Pametna Alternativa

- Primeri U Praksi: LoRA u Akcije

- Zašto LoRA Funkcioniše: Duboko Razumevanje Učenja

- Kada Koristiti LoRA vs. Puno Fine-Tuniranje

- Budućnost je Efikasna

- Često Postavljana Pitanja (FAQ)

Ključne Tačke

- LoRA (Low-Rank Adaptation) omogućava postizanje slične performanse kao tradicionalno fino podešavanje modela uz 99,5% manje parametrizacija.

- Ova metoda značajno smanjuje troškove i vreme treniranja, čineći AI dostupnijim malim preduzećima i pojedincima.

- LoRA ima potencijal da promeni način na koji se AI modeli treniraju i prilagođavaju specifičnim poslovnim potrebama.

Uvod

U modernom svetu veštačke inteligencije (AI), fine-tuning velikih jezičkih modela predstavlja značajan izazov. Proces može biti skup i vremenski zahtevan, što ga čini dostupnim samo onima s velikim resursima. Kako mali i srednji preduzetnici ili pojedinci mogu doprineti ovoj industriji koja se rapidno razvija? Rješenje dolazi u obliku inovativne tehnike poznate kao LoRA (Low-Rank Adaptation). Ovaj članak istražuje kako LoRA pojednostavljuje proces fine-tuninga, omogućavajući ekonomski pristup pionirima u AI-u u Bosni i Hercegovini i širem Balkanu.

Dilema Fine-Tuninga: Zašto je Veličina Bitna?

Tradicija fine-tuninga podrazumijeva promjenu svih parametara modela, što dovodi do ogromne potrošnje resursa. Na primjer, ako uzmemo model s 110 miliona parametara, svaki od tih parametara se ažurira tokom treninga. U praksi, ovo je kao da želite naučiti novu tehniku kuhanja, ali najpre morate zaboraviti sve ono što ste ranije naučili. Ovakav pristup je veoma neefikasan.

Tradicionalni Pristup: Puno Fine-Tuniranje

Tradicionalna metoda fine-tuninga uključuje ažuriranje svakog pojedinačnog parametra modela. Iz perspektive resursa, kompletno fino podešavanje zahteva stotine gigabajta memorije, ogromne troškove i značajno vreme. Barijere koje ovakav pristup stvara čine ga nepristupačnim većini malih i srednjih preduzeća, što dodatno otežava inovacije i prilagodbe.

Novi Pristup: LoRA kao Pametna Alternativa

LoRA postavlja drugačije pitanje: „Šta ako treniramo samo mali deo dodatnih parametara, dok zadržavamo originalni model nepromenjen?“ Ova metoda omogućava korisnicima da koriste svoje postojeće znanje o modelima, dok dodaju samo ono što je neophodno za prilagođavanje novim zadacima.

Kako LoRA Funkcioniše: Tehnička Magija Pojednostavljeno

Kod korišćenja LoRA-e, originalne težine modela ostaju zamrznute, dok se dodaju dve manje matrice koje sadrže dodatne informacije potrebne za prilagođavanje. Umesto da se u potpunosti preuredi model, LoRA koristi matematičku manipulaciju kako bi smanjila broj parametara na koje je potrebno da se fokusiramo.

Dimenzionalna Redukcija

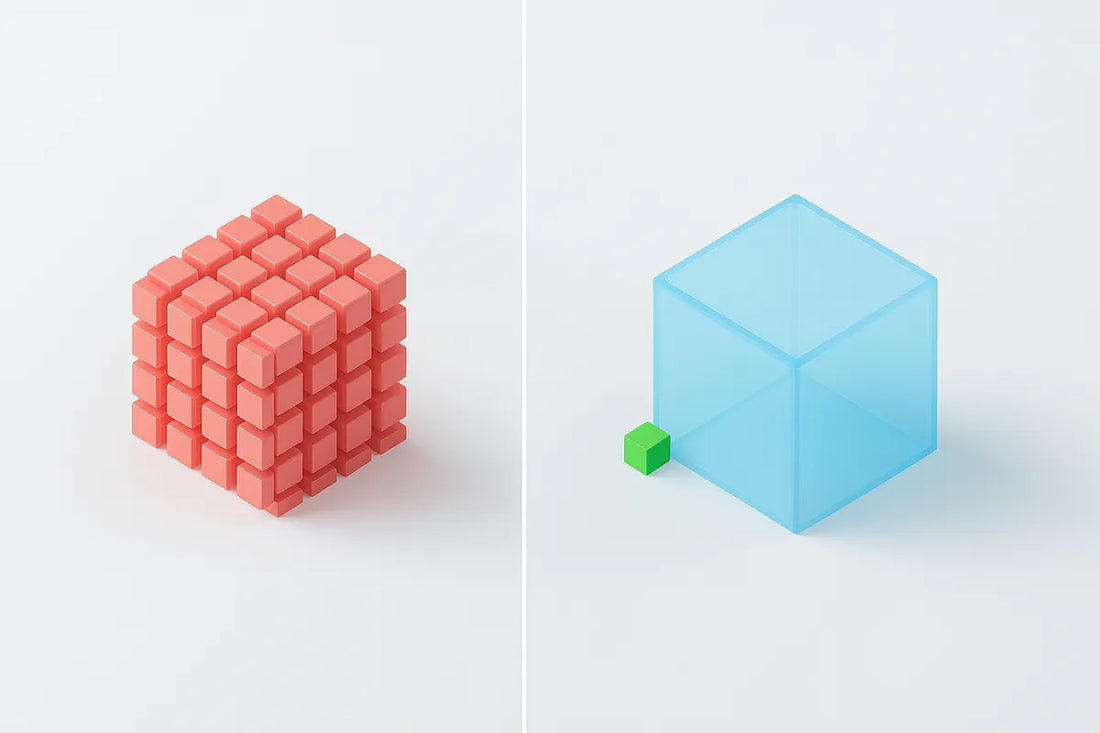

Umesto posmatranja ogromne matrice težina, LoRA je programirana tako da optimizuje proces treniranja kreiranjem dva manja skupa matrica čime se smanjuje broj parametrizacija za čak 97%. Na ovaj način, ubrzava se trening i smanjuju troškovi obuke, doprinoseći efikasnosti celokupnog procesa.

Primeri U Praksi: LoRA u Akcije

Provedena su praktična istraživanja koja su proučila efektivnost LoRA-e, poput analize sentimenta vesti o finansijama koristeći Hugging Face-ovu biblioteku peft. Rezultati su govorili sami za sebe, pokazujući da uz LoRA-ino podešavanje, modeli mogu brzo postići kvalitetne rezultate uz minimalne troškove.

Performanse i Efikasnost

Grafikon performansi između LoRA i tradicionalnog fine-tuninga pokazuje minimalne razlike u tačnosti, ali drastične razlike u potrebnim parametrizacijama i troškovima. U osnovi, LoRA omogućava treniranje sa 99,5% manje parametrizacija uz 35% brže vreme obuke i značajno niže troškove.

Zašto LoRA Funkcioniše: Duboko Razumevanje Učenja

U suštini, LoRA se fokusira na efikasne, generalizovane adaptacije umesto prekomernog prilagođavanja modela specifičnom skupu podataka. Model se obučava u prepoznavanju zadataka i njegovih suptilnosti, omogućavajući dublje razumevanje jezika bez gubitka opšteg znanja.

Kada Koristiti LoRA vs. Puno Fine-Tuniranje

Odabir između LoRA-e i tradicionalnog fine-tuninga zavisi od nekoliko faktora, uključujući resurse i specifičnosti zadatka. LoRA je idealna za:

- Ograničene Računarske Resurse: Kada nemate mogućnost pristupa jakim serverima ili GPU-ima.

- Slične Zadatke: Kada je zadatak blizak originalnom treningu modela, kao što su klasifikacija teksta ili analiza sentimenta.

S druge strane, puno fine-tuniranje može biti itekako relevantno ako su resursi dostupni i ako postoji potreba za maksimalnim izlazom iz modela.

Budućnost je Efikasna

LoRA predstavlja široki pomak ka efikasnijem fine-tuningu, što je ključno za demokratizaciju razvoja AI-a. Kako modeli postaju sve veći, tehnike poput LoRA postaju esencijalne za svaku organizaciju koja želi da ostvari svoje ciljeve bez ogromnih ulaganja.

Često Postavljana Pitanja (FAQ)

P: Šta je LoRA?

O: LoRA je tehnika za smanjenje broja parametara prilikom fine-tuninga jezičkih modela, omogućavajući efikasnije obuke uz manje resursa.

P: Kako LoRA utiče na troškove treniranja?

O: Upotreba LoRA-e smanjuje troškove treniranja, vreme obuke, i potrošnju memorije za čak 99,5%.

P: Kada treba koristiti LoRA umesto traditionalnog fine-tuninga?

O: Preporučuje se korišćenje LoRA-e kada imate ograničene resurse ili kada je vaš zadatak sličan treningu originalnog modela.

P: Mogu li koristiti LoRA sa postojećim modelima?

O: Da, LoRA se može integrisati sa postojećim modelima, što ga čini fleksibilnim rešenjem za fine-tuning.

P: Koje su prednosti LoRA-e u poređenju sa tradicionalnim pristupom?

O: Glavne prednosti uključuju manje potrebnih parametara za trening, brže vrijeme treniranja, niže troškove i održavanje visokih performansi modela.