Kako Funkcionišu Pozivi Velikih Jezičnih Modela (LLM): Vodič za Razvoj Aplikacija

Share

Table of Contents

- Ključne Tačke

- Uvod

- Ko Obespeđuje Modele?

- Postavljanje Osnove — Upute

- Hiperparametri — Kontrole za Uspjeh

- Alati i Funkcionalni Pozivi

- Strukturirani Izlazi sa Šemama

- Streaming i Pouzdanost

- Mini Projekt: Putni Asistent

- Vizualni Tok

- Često Postavljana Pitanja (FAQ)

Ključne Tačke

- Veliki jezični modeli (LLM) dolaze s različitim konfiguracijama i pueden uključivati proprietary i open-source modele.

- Pozivi LLM-ova se temelje na strukturiranim porukama koje uključuju definisane hiperparametre i alate.

- Implementacija pouzdanog i interaktivnog sistema zahtijeva razumijevanje strukture izlaza, korištenje alata, i principa obrade grešaka.

Uvod

U današnjem digitalnom svijetu, umjetna inteligencija i posebno veliki jezični modeli (LLM) postali su ključni alati u razvoju aplikacija. Mnogi programeri i entuzijasti u Bosni i Hercegovini te okolnim zemljama sve više se upuštaju u korištenje ovih sofisticiranih modela. Ovaj vodič pruža detaljan uvid u način na koji se pozivi tim modelima vrše, njihova konfiguracija, kao i bolji uvid u to kako funkcionišu u pozadini. Kroz konkretne primjere, istražit ćemo kako možete optimizirati svoje interakcije s LLM-ovima i kako se oni mogu prilagoditi vašim potrebama.

Ko Obespeđuje Modele?

Veliki jezični modeli mogu se podijeliti u dvije glavne kategorije:

- Proprietarni modeli: Ovi modeli, kao što su OpenAI, Anthropic, Google i Cohere, obično se hostuju i naplaćuju po korištenju. Korištenje ovih modela može donijeti visok nivo efikasnosti, ali često dolazi s višim troškovima.

- Open source LLM-ovi: U ovu kategoriju spadaju modeli kao što su LLaMA, Mistral i Gemma koji se često mogu hostovati lokalno uz pomoć raznih frameworka kao što su Ollama i llama.cpp. Ovi modeli nude fleksibilnost i mogućnost kreiranja vlastitih rješenja bez dodatnih troškova korištenja.

Postavljanje Osnove — Upute

Svaki poziv velikom jezičnom modelu započinje definisanjem poruka:

messages = [

{"role": "system", "content": "Ti si korisni asistent."},

{"role": "user", "content": "Ispričaj zanimljivu činjenicu o Sarajevu."}

]

- Sistem poruka: Ovaj tip poruke postavlja ponašanje modela i definira pravila.

- Korisnička poruka: To je konkretno pitanje ili zahtjev koji upućuje korisnik.

Dodatno, neki modeli podržavaju uključivanje slika unutar poruka, čime se može obogatiti kontekstualna interakcija.

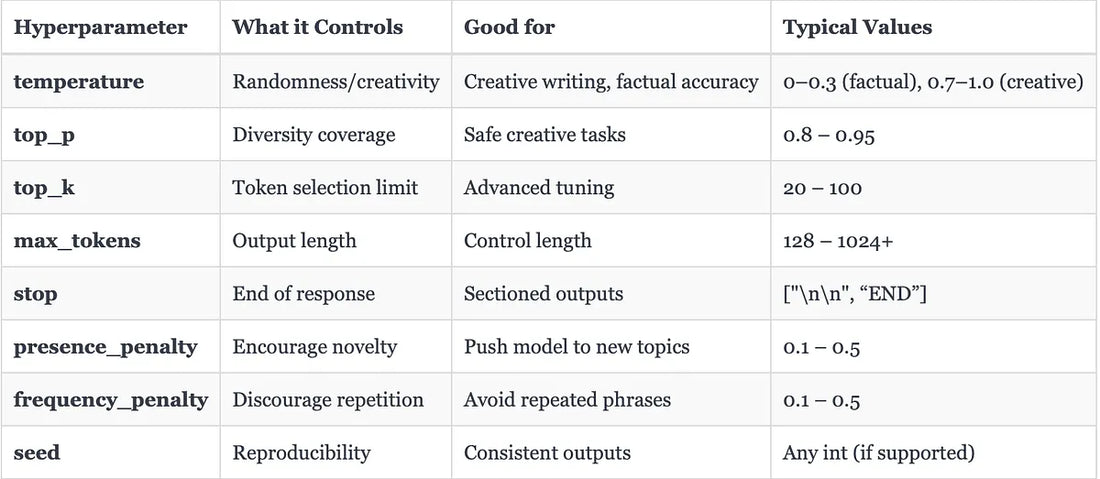

Hiperparametri — Kontrole za Uspjeh

Kao što se osvjetljenje može prilagoditi na telefonu, tako se i pozivi LLM-ovim modelima mogu konfigurisati korištenjem hiperparametara:

response = client.chat.completions.create(

model="gpt-4o-mini",

messages=messages,

temperature=0.7,

top_p=0.9,

max_tokens=200

)

Ove postavke pomažu u kontroli stila, kreativnosti i dužine odgovora. Pravilno podešavanje ovih hiperparametara može značajno unaprijediti korisničko iskustvo i kvalitetu izlaza.

Alati i Funkcionalni Pozivi

U prethodnim člancima smo istraživali kako agenti biraju koji alat pozvati. Međutim, kako zapravo proslijediti alate LLM-u? Bilo koji alat ili funkcija koje želite koristiti dodaju se u API poziv:

import json

tools = [

{

"type": "function",

"function": {

"name": "get_weather",

"description": "Dobijte informacije o vremenu po imenu grada.",

"parameters": {

"type": "object",

"properties": {"city": {"type": "string"}},

"required": ["city"]

}

}

}

]

messages = [{"role": "user", "content": "Trebam kišobran u Banjaluci?"}]

response = client.chat.completions.create(

model="gpt-4o-mini",

messages=messages,

tools=tools,

)

U ovom kodu, model neće direktno pružiti vremenske informacije, već sugerira poziv alatu. Naš kod zatim izvršava tu funkciju i vraća rezultate.

Strukturirani Izlazi sa Šemama

U situacijama kada želimo da izlazi budu u fiksnom JSON obliku, proslijedimo šemu u parametru response_format:

schema = {

"name": "BlogSummary",

"schema": {

"type": "object",

"properties": {

"title": {"type": "string"},

"tags": {"type": "array", "items": {"type": "string"}},

"confidence": {"type": "number", "minimum": 0, "maximum": 1}

},

"required": ["title", "tags", "confidence"]

}

}

Ovo osigurava da izlaz modela uvijek prati definisanu šemu. Za proizvodne aplikacije, preporučuje se korištenje biblioteka kao što su Pydantic ili Marshmallow za provjeru usklađenosti šema.

Streaming i Pouzdanost

Prilikom rada s LLM-ovima, pouzdanost je ključna. Osim osnovnog poziva modelu, često je korisno implementirati streaming:

with client.chat.completions.stream(

model="gpt-4o-mini",

messages=[{"role": "user", "content": "Napiši limerik o podacima."}]

) as stream:

for event in stream:

if event.type == "content.delta":

print(event.delta, end="")

Također, dodavanje rukovanja greškama i ponovnim pokušajem bi bilo izuzetno korisno za proizvodnu upotrebu.

Mini Projekt: Putni Asistent

Zamislimo da izgradimo jednostavnog "Putnog asistenta" koji može pružiti informacije ili pozvati alat za vremensku prognozu i vratiti strukturirane detalje o putovanju.

Definisanje Alata

def get_weather(city: str):

return {"city": city, "temp_c": 27, "condition": "Sunčano"}

Definisanje Šeme za Planiranje Putovanja

trip_schema = {

"name": "TripPlan",

"schema": {

"type": "object",

"properties": {

"destination": {"type": "string"},

"weather": {"type": "object"},

"activities": {"type": "array", "items": {"type": "string"}}

},

"required": ["destination", "weather", "activities"]

}

}

Pozivanje LLM-a

messages = [

{"role": "system", "content": "Ti si putni asistent."},

{"role": "user", "content": "Planiraj jednodnevni izlet u Banjaluku. Predloži 3 aktivnosti."}

]

first = client.chat.completions.create(

model="gpt-4o-mini",

messages=messages,

tools=tools

)

Ako model zatraži poziv alatu, rezultat se dodaje u poruke i zatim se poziva drugi put s strukturiranim izlazom.

Vizualni Tok

Kao dodatak svim ovim procesima, razumijevanje vizualnog toka može pomoći u boljem razumevanju kako LLM-ovi funkcionišu. Diagrami i vizuelni prikazi mogu pokazati tok računske logike u vašem kodu.

Često Postavljana Pitanja (FAQ)

1. Šta su Veliki Jezični Modeli (LLM)? LLM su napredni AI sistemi koji mogu generirati i razumjeti ljudski jezik kroz analizu velikih količina podataka.

2. Kako pozivati alate u LLM-u? Alate možete pozvati putem API poziva, tako što ih uključite u listu kada pozivate model.

3. Kako se postavljaju hiperparametri? Hiperparametri se postavljaju prilikom slanja poziva modelu i određuju stil, kreativnost i dužinu odgovora.

4. Šta su strukture izlaza? To su definicije formata u kojem model mora vratiti rezultate, često u obliku JSON struktura.

5. Kako osigurati pouzdano korištenje LLM-a? Implementacija rukovanja greškama, ponovnim pokušajima i streaming podataka može osigurati visoku dostupnost i pouzdanost vašeg rešenja.

Budući da tehnologije umjetne inteligencije i LLM-ovi postaju sveprisutni, njihovo razumevanje i ispravna implementacija mogu predstavljati značajnu prednost na tržištu rada i tehnologije.